DIGITIMES Research:NVIDIA與英特爾互別苗頭 齊步拉升HPC高速平行運算能力及網通規格

DIGITIMES Research:NVIDIA與英特爾互別苗頭 齊步拉升HPC高速平行運算能力及網通規格。(DIGITIMES Research)

DIGITIMES Research:NVIDIA與英特爾互別苗頭 齊步拉升HPC高速平行運算能力及網通規格。(DIGITIMES Research)

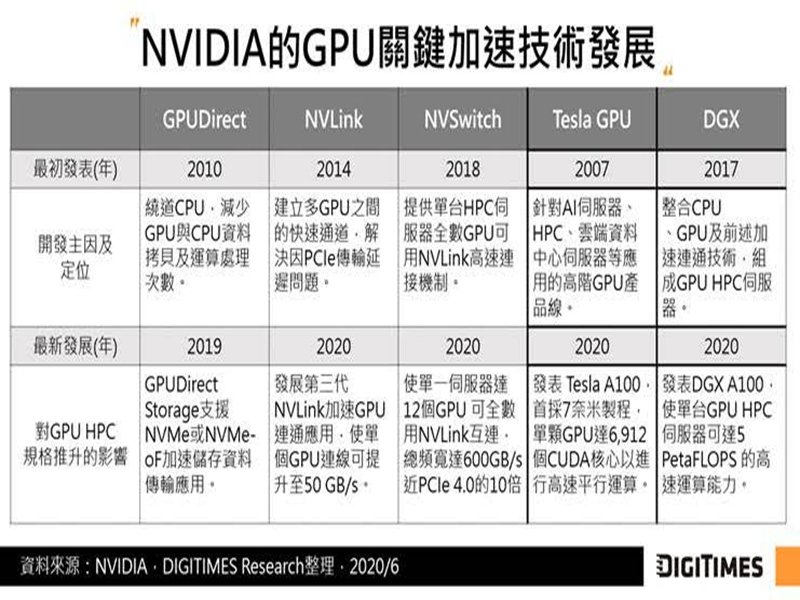

HPC高速運算能力向來由CPU主導,隨著AI平行運算應用日漸盛行,使GPU HPC方案受到重視。GPU領導者NVIDIA近來在HPC市場動作積極,除頻頻推高GPU的高速平行運算能力,另藉由購併取得InfiniBand高速網路技術來提高效能,掀起HPC市場的高速網路戰端,與於400G高速乙太網路方案市場居領先群的英特爾競逐相關市場。DIGITIMES Research分析師龔明德認為,兩強競爭有助於進一步拉升HPC高速運算效能及網路連通能力。

NVIDIA藉由購併高速網路領導業者Mellanox來掌握InfiniBand技術。InfiniBand主要用於HPC高速網路,同時也為NVIDIA的GPUDirect RDMA (Remote Direct Memory Access)互連技術核心,導入InfiniBand將有利於NVIDIA繞開CPU,加速GPU與週邊裝置的高速資料傳輸能力。

為回應NVIDIA於2019年3月剛宣布收購Mellanox之舉,英特爾於2019年6月購併網通業者Barefoot。藉此,英特爾將可提供雲端服務商或企業資料中心未來更多具彈性客製化的軟硬體網通方案,應用於防火牆、負載平衡、網路效能分析及遠端監控等,進而在HPC高速網通市場中保有一席之地。

目前CPU及GPU大廠戰場已從既有HPC晶片方案,進一步延伸到HPC高速網通能力,而在兩強競爭過程下,可望進一步突破HPC伺服器的網路連通應用瓶頸,晶片商也可整合高速網路互連技術,並更專注發展新一代HPC方案,推升HPC技術邁向新里程碑及創造市場成長契機。

NVIDIA藉由購併高速網路領導業者Mellanox來掌握InfiniBand技術。InfiniBand主要用於HPC高速網路,同時也為NVIDIA的GPUDirect RDMA (Remote Direct Memory Access)互連技術核心,導入InfiniBand將有利於NVIDIA繞開CPU,加速GPU與週邊裝置的高速資料傳輸能力。

為回應NVIDIA於2019年3月剛宣布收購Mellanox之舉,英特爾於2019年6月購併網通業者Barefoot。藉此,英特爾將可提供雲端服務商或企業資料中心未來更多具彈性客製化的軟硬體網通方案,應用於防火牆、負載平衡、網路效能分析及遠端監控等,進而在HPC高速網通市場中保有一席之地。

目前CPU及GPU大廠戰場已從既有HPC晶片方案,進一步延伸到HPC高速網通能力,而在兩強競爭過程下,可望進一步突破HPC伺服器的網路連通應用瓶頸,晶片商也可整合高速網路互連技術,並更專注發展新一代HPC方案,推升HPC技術邁向新里程碑及創造市場成長契機。